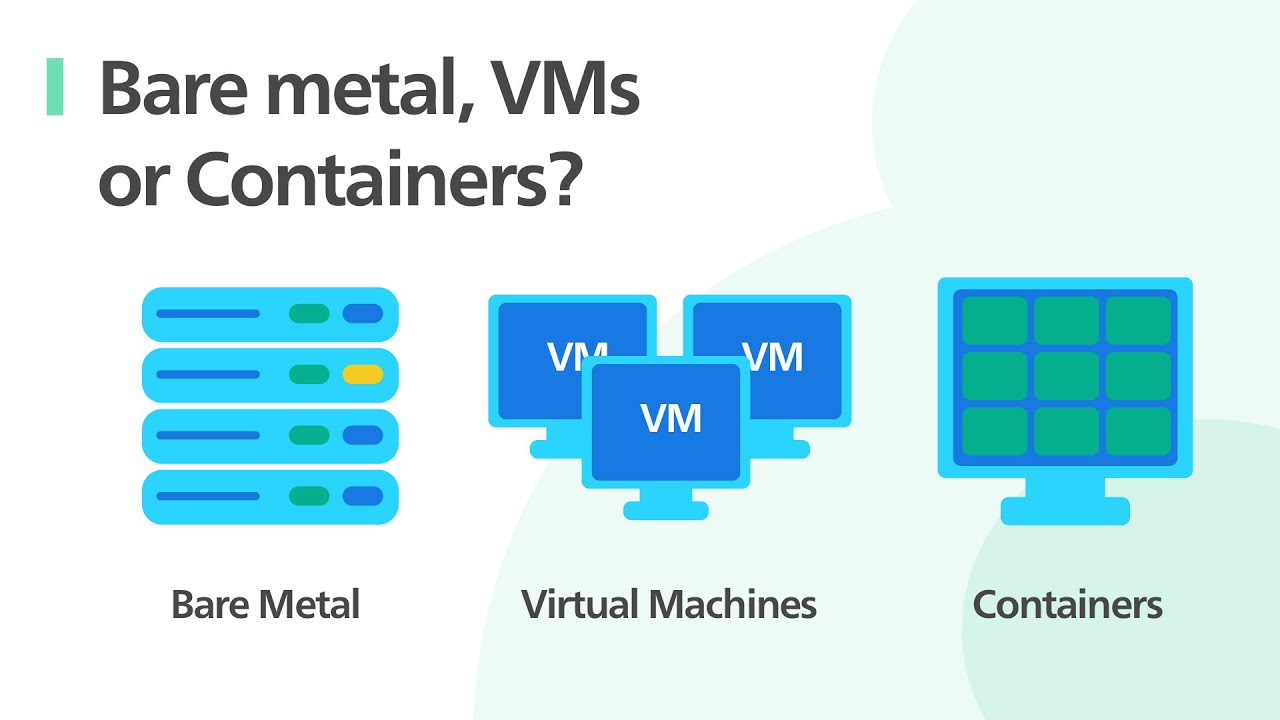

Neste artigo, exploraremos os fundamentos da infraestrutura de TI que moldou a computação como conhecemos.

Desde o tradicional bare metal, passando pelas revolucionárias Máquinas Virtuais (VMs), até a emergência dos eficientes Containers, descubra como cada tecnologia transformou a forma de gerir e escalar serviços digitais.

Entendendo o Bare Metal

Entender o conceito de “bare metal” é fundamental para compreender a evolução da infraestrutura de TI.

Em sua essência, “bare metal” refere-se aos servidores físicos, sem nenhuma camada de virtualização aplicada.

Isso significa que o sistema operacional é instalado diretamente no hardware, permitindo um controle total sobre os recursos da máquina.

Esta abordagem, prevalente nos primórdios da computação, era valorizada por sua eficiência e desempenho, uma vez que não havia camadas adicionais de software entre o sistema operacional e o hardware.

A natureza direta dessa relação permitia que os administradores de sistemas otimizassem os recursos disponíveis para atender às exigências específicas de cada aplicação, maximizando assim a utilização e o desempenho do hardware.

Além disso, servidores bare metal oferecem uma segurança aprimorada e menor latência, aspectos críticos para operações que demandam alto desempenho, como bancos de dados de alta velocidade e aplicações críticas.

A ausência de uma camada de virtualização minimiza a superfície de ataque, tornando o sistema intrinsecamente mais seguro.

No entanto, é importante notar que essa vantagem vem com a responsabilidade adicional de gerenciar o hardware diretamente, exigindo uma equipe técnica qualificada para realizar configurações e manutenções.

Essa ligação intrínseca entre o software e o hardware define a arquitetura do bare metal, diferenciando-a fundamentalmente de formatos mais modernos de computação, como máquinas virtuais e containers, os quais oferecem níveis variados de abstração e isolamento, facilitando a gestão de recursos mas introduzindo novas camadas de complexidade.

A Era dos Servidores Bare Metal

Na aurora da computação moderna, os servidores eram invariavelmente bare metal, uma realidade que moldou profundamente o desenvolvimento inicial das tecnologias de rede e computação.

Esses servidores físicos, desprovidos de qualquer camada de abstração ou virtualização, eram configurados e otimizados para executar tarefas específicas, desde hospedagem de sites até aplicações empresariais complexas.

Este cenário começou a ganhar forma nas décadas de 1950 e 1960, quando os computadores ocupavam grandes salas e exigiam uma infraestrutura física substantiva para operar.

A relação direta com o hardware proporcionava aos técnicos um controle absoluto sobre o desempenho e a configuração do sistema, permitindo otimizações que maximizavam a eficiência operacional.

No entanto, essa configuração também apresentava limitações significativas em termos de flexibilidade e escalabilidade, uma vez que cada servidor bare metal era dedicado a uma tarefa ou sistema operacional específico, dificultando a partilha de recursos e a rápida adaptação a novas demandas.

À medida que as necessidades das organizações evoluíam e a complexidade dos ambientes de TI aumentava, surgia a necessidade de abordagens mais flexíveis e eficientes.

O cenário começou a mudar com o advento da virtualização na década de 1960, inicialmente como uma forma de particionar grandes sistemas mainframe para permitir que múltiplos usuários e aplicações compartilhassem o mesmo hardware sem interferência.

Esta transformação tecnológica abriu caminho para o desenvolvimento de máquinas virtuais (VMs), permitindo que um único servidor bare metal hospedasse múltiplos sistemas operacionais e aplicações, criando uma separação lógica que aumentava a utilização do hardware e oferecia maiores possibilidades de isolamento e segurança.

Essa evolução não apenas superou algumas das limitações intrínsecas aos servidores bare metal, como também preparou o terreno para inovações subsequentes, incluindo o desenvolvimento e a popularização de contêineres, que promoveram ainda mais a eficiência, a portabilidade e a escalabilidade em ambientes de computação modernos.

A história dos servidores bare metal é, portanto, a fundação sobre a qual a infraestrutura de TI contemporânea foi construída, representando o ponto de partida para as rápidas inovações que caracterizam a era digital atual.

Fundamentos da Virtualização

À medida que a era dos servidores bare metal evoluía, surgiu um conceito revolucionário que mudaria para sempre a maneira como pensamos sobre a gestão e o aproveitamento dos recursos de TI: a virtualização.

Essencialmente, a virtualização refere-se à criação de uma versão virtual, ao invés de física, de algo, como um sistema operacional, um servidor, um dispositivo de armazenamento ou recursos de rede.

A habilidade de rodar múltiplos sistemas operacionais simultaneamente em um único hardware físico não apenas expandiu as possibilidades de uso de infraestruturas de TI existentes, mas também introduziu um nível de flexibilidade, eficiência e economia anteriormente inatingíveis.

Anteriormente, a instalação de vários sistemas operacionais em um único servidor físico resultava em uma complexa divisão de recursos que frequentemente levava ao subaproveitamento de capacidades.

Com a chegada da virtualização, tornou-se possível separar o hardware físico dos sistemas operacionais e das aplicações que rodam sobre este, permitindo que múltiplas “máquinas virtuais” (VMs) coexistam no mesmo ambiente físico sem interferir umas com as outras.

Este avanço tecnológico significou uma revolução no gerenciamento de recursos de TI, otimizando o uso de hardware, reduzindo custos de energia e de manutenção, e oferecendo uma flexibilidade sem precedentes na alocação de recursos conforme necessário.

Este conceito será explorado em profundidade no próximo capítulo, detalhando a estrutura e o funcionamento das máquinas virtuais e o papel vital dos hipervisores neste contexto.

A virtualização, portanto, estabelece-se como a pedra angular para o desenvolvimento de tecnologias emergentes de infraestrutura de TI, pavimentando o caminho para inovações como a computação em nuvem e os containers.

O Mundo das Máquinas Virtuais

Uma Máquina Virtual (VM) é uma representação digital de um sistema de computador, funcionando em ambiente isolado.

Essa tecnologia utiliza software chamado hypervisor para emular o hardware físico, o que inclui CPU, memória, armazenamento e dispositivos de rede, permitindo assim que vários sistemas operacionais rodem simultaneamente em um único hardware físico.

O hypervisor atua como uma camada de gestão entre o hardware físico e as VMs, administrando recursos e garantindo que cada VM tenha acesso aos componentes necessários para operar de forma eficaz sem interferir uma com a outra.

A arquitetura típica de uma VM é composta por uma combinação de recursos de hardware virtualizados.

Esses incluem um BIOS virtual, uma placa-mãe virtual, processadores virtuais, memória RAM virtual e dispositivos de armazenamento e entrada/saída, todos simulados pelo hypervisor.

Esse ambiente virtualizado possibilita que a VM opere como se fosse um computador físico independente, executando seu próprio sistema operacional e aplicações.

Esse modelo de emulação permite uma série de vantagens em termos de flexibilidade, eficiência e gestão de recursos de TI, pois as VMs podem ser facilmente criadas, modificadas e movidas entre diferentes servidores físicos, de acordo com as necessidades de carga de trabalho, sem a necessidade de modificar o hardware subjacente.

Principais Benefícios das VMs

Os principais benefícios das Máquinas Virtuais (VMs) são derivados de sua capacidade de emular vários ambientes de sistema operacional independentes em um único hardware físico, o que introduz um nível de flexibilidade e isolamento sem precedentes no ambiente computacional.

O isolamento, uma característica fundamental das VMs, permite que cada máquina virtual funcione de maneira independente, como se fosse um servidor separado. Isso significa que as aplicações rodando em uma VM estão isoladas das aplicações em outras VMs no mesmo host físico.

Esta separação protege os sistemas contra falhas de software ou ataques cibernéticos que afetam outras VMs, garantindo um nível de segurança e estabilidade operacional.

Além disso, a flexibilidade oferecida pelas VMs é uma vantagem substancial. Por meio da virtualização, é possível provisionar, de maneira rápida e dinâmica, novos ambientes de software com diferentes sistemas operacionais ou configurações, sem a necessidade de novo hardware físico.

Esta capacidade permite às empresas adaptarem-se rapidamente às mudanças nas necessidades de TI, experimentarem novas tecnologias sem riscos substanciais ou lançarem novos ambientes de teste e desenvolvimento sem impactar a operação dos sistemas críticos existentes.

A melhor utilização dos recursos de computação também é um benefício significativo das VMs.

Ao possibilitar que múltiplas máquinas virtuais compartilhem os mesmos recursos físicos, como CPU, memória e armazenamento, as VMs maximizam a eficiência desses recursos, reduzindo o desperdício e diminuindo a necessidade de investimentos adicionais em hardware.

Este compartilhamento de recursos facilita uma gestão mais eficiente, permitindo que os administradores de sistema ajustem dinamicamente a alocação de recursos de acordo com as necessidades das aplicações, resultando em uma infraestrutura de TI mais ágil e econômica.

Limitações e Desvantagens das VMs

Apesar das muitas vantagens apresentadas pelas Máquinas Virtuais (VMs) em termos de isolamento, flexibilidade e otimização de recursos, enfrentam também diversas limitações e desvantagens, principalmente relacionadas à sobrecarga de performance e à complexidade de gerenciamento.

A natureza da virtualização de hardware, fundamental para a criação e funcionamento das VMs, introduz uma camada adicional entre o sistema operacional convidado e o hardware físico.

Esta camada, apesar de ser uma poderosa ferramenta de abstração, também é uma fonte de sobrecarga de performance.

Cada operação realizada dentro de uma VM precisa transitar por essa camada de virtualização, o que pode resultar em tempos de resposta mais lentos em comparação com os sistemas operacionais executados diretamente no hardware (bare metal).

Além da sobrecarga de performance, outro ponto de atenção é a complexidade associada à manutenção e gerenciamento de um ambiente virtualizado.

A gestão de múltiplas VMs exige ferramentas e habilidades específicas, uma vez que cada máquina virtual funciona de forma quase idêntica a um computador físico independente, requerendo sua própria manutenção do sistema operacional, atualizações de segurança, backups e monitoramento.

Esse cenário pode se tornar particularmente desafiador em ambientes com um grande número de VMs, multiplicando os esforços necessários para garantir a segurança, a performance e a disponibilidade dos sistemas.

Consequentemente, organizações que utilizam intensamente máquinas virtuais devem estar preparadas para investir em ferramentas avançadas de gestão e em profissionais qualificados para lidar com essas complexidades, aspectos que podem mitigar, mas não eliminar completamente os desafios inerentes à virtualização de servidores.

Introdução aos Containers

Os Containers são uma solução tecnológica projetada para facilitar a criação, implantação e execução de aplicações, permitindo que elas operem em ambientes isolados.

Na essência, um Container encapsula o código de uma aplicação juntamente com todas as suas dependências (bibliotecas, frameworks, etc.) em um único pacote.

Isso significa que a aplicação pode rodar de maneira consistente em qualquer ambiente, seja em um desenvolvimento local, em um teste de QA ou no ambiente de produção, independentemente das configurações desses ambientes.

A principal diferença ao compararmos Containers com Máquinas Virtuais (VMs) está na abstração da camada sobre a qual eles operam.

Enquanto as VMs virtualizam o hardware criando múltiplos sistemas operacionais totalmente funcionais em cima de um sistema hospedeiro, os Containers virtualizam o sistema operacional, permitindo que múltiplas instâncias de Containers compartilhem o mesmo núcleo do sistema operacional hospedeiro, mas ainda assim, executem isoladamente.

Essa característica de compartilhar o mesmo núcleo do sistema operacional elimina a necessidade de um sistema operacional completo para cada instância, como é o caso das VMs, tornando os Containers significativamente mais leves e eficientes em termos de uso de recursos como memória e processamento.

Isso não apenas reduz a sobrecarga de recursos, que era uma limitação notável com as VMs, mas também acelera significativamente o tempo de início das aplicações.

Enquanto uma VM pode levar minutos para inicializar, um Container pode fazer isso em questão de segundos.

Essa eficiência implica, portanto, não apenas em economia direta de recursos de hardware, mas também em uma agilidade operacional melhorada, permitindo que as equipes de desenvolvimento implementem e atualizem aplicações mais rapidamente e com maior frequência.

Contudo, essa vantagem vem com considerações próprias de segurança e isolamento, já que compartilhar o mesmo Kernel do sistema operacional pode apresentar riscos se não gerenciado com as práticas apropriadas, o que abordaremos nos benefícios dos Containers no próximo segmento deste artigo.

Explorando os Benefícios dos Containers

A adoção de containers pode trazer uma série de benefícios significativos quando comparada à utilização exclusiva de máquinas virtuais (VMs) ou servidores bare metal. Um dos principais atrativos dos containers é a portabilidade que eles oferecem.

Uma vez que um container encapsula tudo o que é necessário para executar um software, incluindo o código, as runtime libraries, as dependências e os arquivos de sistema necessários, este pode ser movido entre diferentes ambientes de hospedagem — desde o desenvolvimento local até a produção em larga escala na nuvem — sem necessidade de alterações ou adaptações. Essa capacidade elimina o problema comum do “funciona no meu computador”, facilitando a gestão de ambientes complexos e a entrega contínua de software.

Além da portabilidade, os containers são conhecidos pela sua economia de recursos. Ao compartilhar o mesmo sistema operacional anfitrião, eles são capazes de iniciar mais rapidamente e consumir menos recursos do que as VMs, que precisam carregar seu próprio sistema operacional.

Esta eficiência permite que um número maior de aplicações seja executado no mesmo hardware, reduzindo custos e aumentando a eficiência do uso de recursos.

Para desenvolvedores e operações de TI, os containers também oferecem uma conveniência sem precedentes ao criar ambientes replicáveis.

Através do uso de imagens de containers, é possível garantir que cada instância da aplicação seja executada exatamente da mesma forma, em qualquer ambiente ou etapa do ciclo de desenvolvimento.

Isso simplifica os fluxos de trabalho de desenvolvimento, testes e implantação, contribuindo para a adoção de práticas de integração contínua (CI) e entrega contínua (CD), essenciais para o desenvolvimento ágil de software.

Portanto, ao combinar portabilidade, economia de recursos e facilidade para desenvolver em ambientes replicáveis, os containers se estabelecem como uma ferramenta poderosa para modernizar a infraestrutura de TI, otimizar recursos e acelerar o ciclo de vida de desenvolvimento de software.

Hospedagem de VMs em Bare Metal

Hospedar Máquinas Virtuais (VMs) em um servidor bare metal representa uma estratégia que combina o poder absoluto de processamento de um hardware físico dedicado com a incrível flexibilidade oferecida pela virtualização.

Ao optar por esse modelo, organizações podem aproveitar a capacidade máxima dos recursos do servidor bare metal – como CPU, memória e armazenamento – sem a partilha desses recursos entre várias instâncias, como aconteceria em ambientes de hospedagem compartilhada.

Isso resulta em um desempenho superior, pois cada VM pode ser configurada para otimizar o uso dos recursos de acordo com as necessidades específicas da aplicação ou serviço que está sendo executado.

Além disso, a virtualização em servidores bare metal permite uma flexibilidade operacional notável. Administradores podem criar, configurar, clonar, migrar e eliminar VMs com facilidade, adaptando-se rapidamente às mudanças nas demandas de carga de trabalho ou ao implementar novos serviços.

Esta abordagem não apenas simplifica a gestão do data center, mas também melhora significativamente a eficiência da utilização de recursos, reduzindo custos operacionais.

A possibilidade de isolar ambientes em VMs individuais também aumenta a segurança, pois falhas ou vulnerabilidades em uma VM não afetam diretamente as demais.

Combinar a robustez do bare metal com a agilidade da virtualização representa, portanto, uma solução equilibrada para muitas organizações que buscam otimizar sua infraestrutura de TI sem comprometer o desempenho ou a segurança.

Containers em Bare Metal

Hospedar containers diretamente em servidores bare metal pode ser uma estratégia vantajosa para muitos cenários de uso, especialmente quando a eficiência, a escalabilidade, e a rapidez na implementação são críticas.

A principal vantagem dessa abordagem reside na possibilidade de aproveitar ao máximo os recursos do hardware sem a sobrecarga adicional que a virtualização tradicional pode acarretar.

Containers são projetados para serem leves, permitindo que um maior número deles opere em um único servidor bare metal comparado ao número de máquinas virtuais que o mesmo servidor poderia suportar.

Isso se traduz em maior eficiência e melhor utilização dos recursos de hardware disponíveis, o que é particularmente benéfico em ambientes de alta demanda onde cada ciclo de CPU conta.

Além disso, a hospedagem de containers em bare metal oferece vantagens significativas em termos de escalabilidade e rapidez na implementação.

Containers podem ser iniciados e parados quase instantaneamente, facilitando o dimensionamento rápido de aplicações de acordo com as necessidades.

Esta capacidade de responder rapidamente a mudanças na demanda é crucial em ambientes dinâmicos, como é o caso de muitas aplicações web e móveis atuais.

A ausência de uma camada de virtualização intermediária também simplifica a arquitetura geral do sistema, tornando a implementação e a gestão dos containers mais diretas.

Isso pode reduzir significativamente o tempo necessário para colocar novas aplicações em funcionamento ou para escalar as existentes, contribuindo para uma maior agilidade do negócio.

Portanto, a combinação de bare metal com tecnologia de containerização representa uma poderosa abordagem para otimizar tanto o desempenho quanto a eficiência operacional.

Checklist para Escolher Entre Bare Metal, VMs ou Containers

Decidir entre bare metal, VMs (Máquinas Virtuais) ou containers exige uma análise detalhada das necessidades específicas de cada cenário de implantação.

Começando com a performance, bare metal é a escolha ideal para aplicações que demandam o máximo de recursos disponíveis, como base de dados de alto desempenho ou jogos online, uma vez que não existe a overhead de virtualização.

VMs, por sua vez, oferecem um equilíbrio entre isolamento e desempenho, sendo adequadas para cenários onde a consolidação de servidores e a flexibilidade são prioridades.

Containers destacam-se quando a preocupação central é a escalabilidade e a rapidez na implementação de aplicações, especialmente em ambientes de desenvolvimento e operações integrados (DevOps), onde a agilidade e a eficiência no uso dos recursos são críticas.

Quando se trata de escalabilidade, containers são naturalmente projetados para facilitar a orquestração e o gerenciamento em larga escala, tornando-os excepcionalmente bons para microserviços e aplicações distribuídas.

VMs, com sua capacidade de encapsular um sistema operacional completo, oferecem uma alternativa robusta para a escalabilidade, embora com maior consumo de recursos.

Bare metal, apesar de ser menos flexível neste aspecto, pode ser a melhor opção para aplicações críticas que necessitam de toda a capacidade de hardware exclusiva para si.

Quanto à segurança, tanto VMs como containers proporcionam um bom nível de isolamento; contudo, a modelagem de segurança difere significativamente, sendo necessário avaliar as características específicas de cada ambiente.

VMs possuem fronteiras de isolamento mais rígidas em comparação aos containers, que compartilham o mesmo kernel do sistema operacional hospedeiro.

Por último, a questão do custo deve ser considerada cuidadosamente, pois o modelo de bare metal pode levar a investimentos iniciais mais altos e custos operacionais fixos, enquanto VMs e containers são geralmente mais associados a custos variáveis e economia com a densidade de consolidação e a eficiência na alocação de recursos.

Avaliar cuidadosamente cada um desses aspectos é essencial para fazer a escolha certa entre bare metal, VMs e containers, garantindo assim que a infraestrutura de TI escolhida alinhe-se perfeitamente às necessidades de negócio, oferecendo o melhor equilíbrio entre performance, escalabilidade, segurança e custo.

Concluindo, cada abordagem – bare metal, Máquinas Virtuais e Containers – possui características únicas que atendem a diferentes necessidades.

Compreender as vantagens e limitações de cada uma é crucial para otimizar a infraestrutura de TI e alcançar a eficiência desejada em projetos de qualquer envergadura.

A Target é Especializada em Softwares e Serviços para Telecomunicações e TI

A Target Solutions é uma empresa de Tecnologia da Informação e Comunicação (TIC) especializada em Desenvolvimento de Softwares, Integração de Sistemas, Automação e Monitoramento de Infraestrutura de TI, Serviços de Suporte, Tecnologia Open Source e DevOps.

Temos uma longa experiência na escolha, implantação e suporte de soluções que utilizam a tecnologia Open Source, e destacamos abaixo algumas áreas com projetos entregues:

- Monitoramento de Ativos

- Backup Gerenciado

- Automação e Orquestração de Processos

- Solução de API Management

- Automação de Infraestrutura

Nossa equipe técnica possui alta capacitação e amplo conhecimento e experiência em ambientes heterogêneos de hardware e software, além de estar sempre em constante atualização com as novidades do mercado para contribuir em nosso processo de melhoria contínua.

Clique aqui para agendar um contato com um de nossos Consultores Especializados.

Autor deste Artigo: Equipe de DevOps da Target Solutions

Revisão: Paulo Florêncio, Diretor Comercial da Target Solution